概述

笔者认为,在研究一个开源项目的之前,看看起依赖管理的文件,比如说 Maven 的 pom.xml 文件,或者是 Sbt 的 build.sbt 文件。

Delta Lake依赖了什么jar包

查看 build.sbt 文件,可以看到 Delta Lake 确实是构建于 Spark 之上的,因为他除了依赖 Spark 几个依赖外,没有再额外引入一些 jar 包了,也是因为 Spark 项目本身比较庞大,已经引入了足够用的一些依赖工具包了。

1

2

3

4

5

6

7

8

9

10

11

12

13

|

libraryDependencies ++= Seq(

// Adding test classifier seems to break transitive resolution of the core dependencies

"org.apache.spark" %% "spark-hive" % sparkVersion.value % "provided",

"org.apache.spark" %% "spark-sql" % sparkVersion.value % "provided",

"org.apache.spark" %% "spark-core" % sparkVersion.value % "provided",

"org.apache.spark" %% "spark-catalyst" % sparkVersion.value % "provided",

// Test deps

"org.scalatest" %% "scalatest" % "3.0.5" % "test",

"org.apache.spark" %% "spark-catalyst" % sparkVersion.value % "test" classifier "tests",

"org.apache.spark" %% "spark-core" % sparkVersion.value % "test" classifier "tests",

"org.apache.spark" %% "spark-sql" % sparkVersion.value % "test" classifier "tests"

)

|

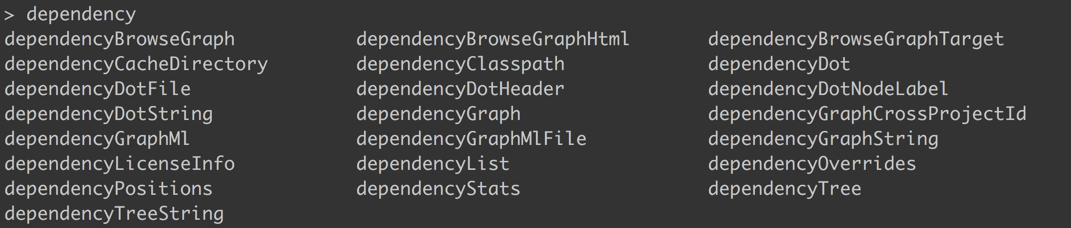

sbt 有个插件可以参考下,可以输出类似于 Maven dependency tree 的效果。

关于依赖,主要定位到文件的 libraryDependencies,可以看到,基本都是 provided,所以这个时候用 dependencyTree 是打不出依赖树的。

上图可以看到,插件的 dependency 有很多类似的命令,输入 dependencyTree 命令看到如下输出,只会默认打印 compile 的依赖。

这里还有一个命令 provided:dependencyTree,表示把 provided 的依赖树也会打印出来。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

> provided:dependencyTree

[warn] Credentials file /Users/runzhliu/.bintray/.credentials does not exist

[info] io.delta:delta-core_2.11:0.1.1-SNAPSHOT

[info] +-org.apache.spark:spark-catalyst_2.11:2.4.2

[info] | +-commons-codec:commons-codec:1.10

[info] | +-org.antlr:antlr4-runtime:4.7

[info] | +-org.apache.spark:spark-core_2.11:2.4.2 [S]

[info] | | +-com.clearspring.analytics:stream:2.7.0

...

...

[info] +-org.apache.spark:spark-sketch_2.11:2.4.2

[info] | +-org.apache.spark:spark-tags_2.11:2.4.2 [S]

[info] | | +-org.spark-project.spark:unused:1.0.0

[info] | |

[info] | +-org.spark-project.spark:unused:1.0.0

[info] |

[info] +-org.apache.spark:spark-tags_2.11:2.4.2 [S]

[info] | +-org.spark-project.spark:unused:1.0.0

[info] |

[info] +-org.apache.xbean:xbean-asm6-shaded:4.8

[info] +-org.spark-project.spark:unused:1.0.0

[info]

[success] Total time: 3 s, completed 2019-4-27 0:04:50

|

如上图,可以打印出所有的依赖树。

总结

Delta Lake 是构建于 Spark 之上的项目,所以依赖都关于 Spark 的其他 lib。由于 Delta Lake 并没有依赖更多的项目(Spark 其实已经很多了…),所以后面我们去探索代码的时候,只要有 Spark 基础的同学,应该都可以很快上手。

警告

本文最后更新于 2017年2月1日,文中内容可能已过时,请谨慎参考。